Para atender às necessidades dos serviços em nuvem, a rede está sendo gradualmente dividida em Underlay e Overlay. A rede Underlay consiste em equipamentos físicos, como roteamento e comutação, presentes nos data centers tradicionais, que ainda priorizam a estabilidade e oferecem recursos confiáveis de transmissão de dados. A rede Overlay, por sua vez, é a rede de serviços encapsulada sobre ela, mais próxima do usuário final, utilizando protocolos como VXLAN ou GRE, para proporcionar aos usuários serviços de rede fáceis de usar. As redes Underlay e Overlay são relacionadas e independentes, podendo evoluir de forma autônoma.

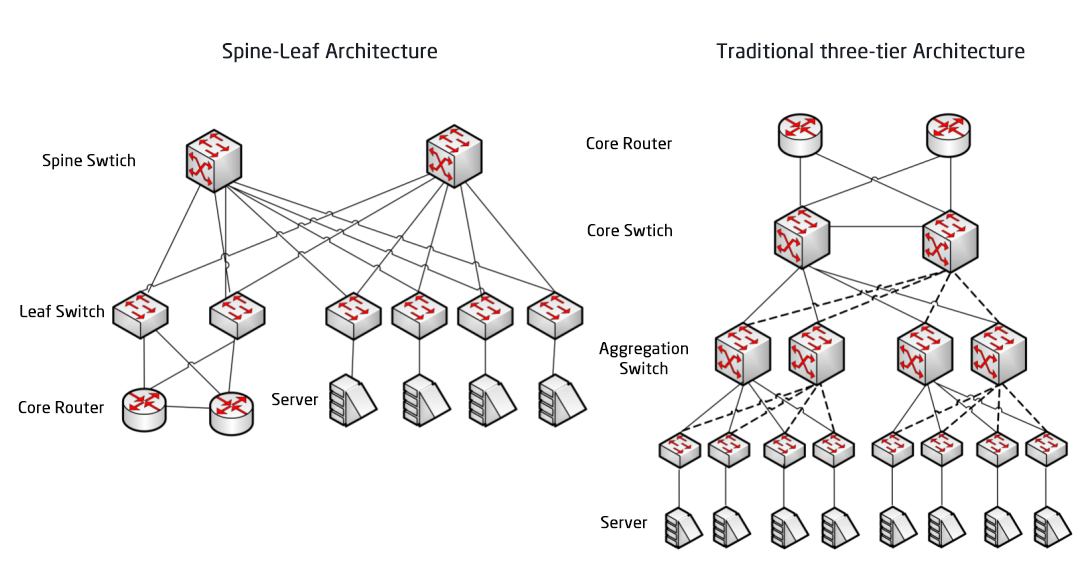

A rede subjacente é a base da rede. Se a rede subjacente for instável, não há SLA para o negócio. Após a arquitetura de rede de três camadas e a arquitetura de rede Fat-Tree, a arquitetura de rede do data center está passando por uma transição para a arquitetura Spine-Leaf, que inaugurou a terceira aplicação do modelo de rede CLOS.

Arquitetura de rede de data center tradicional

Design de três camadas

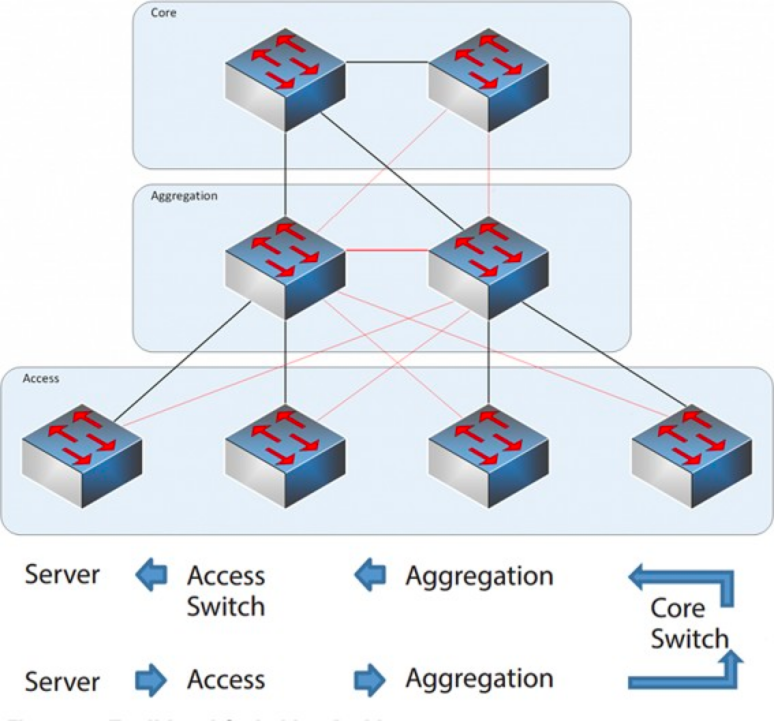

De 2004 a 2007, a arquitetura de rede de três camadas foi muito popular em data centers. Ela possui três camadas: a camada central (a espinha dorsal de comutação de alta velocidade da rede), a camada de agregação (que fornece conectividade baseada em políticas) e a camada de acesso (que conecta as estações de trabalho à rede). O modelo é o seguinte:

Arquitetura de rede de três camadas

Camada Central: Os switches centrais fornecem encaminhamento de alta velocidade de pacotes para dentro e para fora do centro de dados, conectividade com as múltiplas camadas de agregação e uma rede de roteamento L3 resiliente que normalmente atende a toda a rede.

Camada de agregação: O switch de agregação se conecta ao switch de acesso e fornece outros serviços, como firewall, descarregamento de SSL, detecção de intrusão, análise de rede, etc.

Camada de Acesso: Os switches de acesso geralmente estão localizados no Topo do Rack, por isso também são chamados de switches ToR (Top of Rack), e se conectam fisicamente aos servidores.

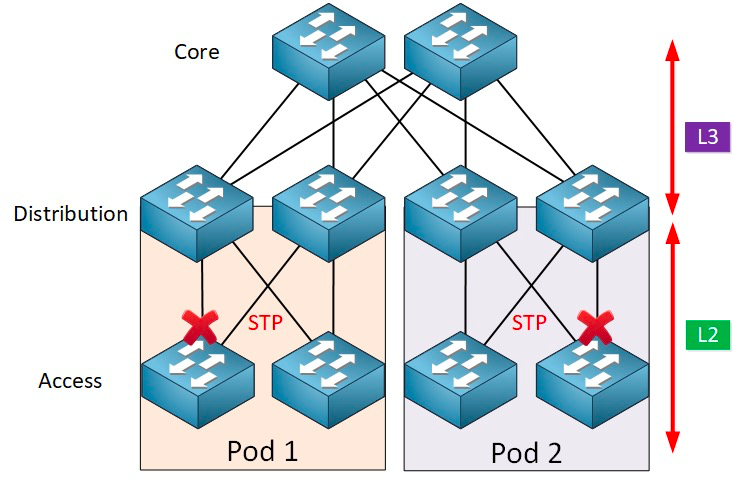

Normalmente, o switch de agregação é o ponto de demarcação entre as redes L2 e L3: a rede L2 está abaixo do switch de agregação e a rede L3 está acima. Cada grupo de switches de agregação gerencia um Ponto de Entrega (POD), e cada POD é uma rede VLAN independente.

Protocolo Network Loop e Spanning Tree

A formação de loops é causada principalmente pela confusão gerada por caminhos de destino pouco claros. Ao construir redes, os usuários geralmente utilizam dispositivos e links redundantes para garantir a confiabilidade, o que inevitavelmente leva à formação de loops. A rede de camada 2 opera no mesmo domínio de broadcast, e os pacotes de broadcast são transmitidos repetidamente no loop, formando uma tempestade de broadcast, que pode causar bloqueio de portas e paralisação de equipamentos instantaneamente. Portanto, para evitar tempestades de broadcast, é essencial prevenir a formação de loops.

Para evitar a formação de loops e garantir a confiabilidade, é possível transformar dispositivos e links redundantes em dispositivos e links de backup. Ou seja, as portas e links de dispositivos redundantes são bloqueados em circunstâncias normais e não participam do encaminhamento de pacotes de dados. Somente quando o dispositivo, porta ou link de encaminhamento atual falha, resultando em congestionamento da rede, as portas e links de dispositivos redundantes são liberados para que a rede possa ser restaurada ao normal. Esse controle automático é implementado pelo Spanning Tree Protocol (STP).

O protocolo Spanning Tree opera entre a camada de acesso e a camada de destino, e em sua essência está um algoritmo de árvore de abrangência executado em cada ponte habilitada para STP, projetado especificamente para evitar loops de ponte na presença de caminhos redundantes. O STP seleciona o melhor caminho de dados para encaminhar mensagens e bloqueia os links que não fazem parte da árvore de abrangência, deixando apenas um caminho ativo entre quaisquer dois nós da rede, enquanto o outro link de uplink será bloqueado.

O STP oferece muitas vantagens: é simples, plug-and-play e requer pouca configuração. As máquinas dentro de cada pod pertencem à mesma VLAN, portanto o servidor pode migrar a localização arbitrariamente dentro do pod sem modificar o endereço IP e o gateway.

No entanto, o STP não pode usar caminhos de encaminhamento paralelos, pois sempre desabilita caminhos redundantes dentro da VLAN. Desvantagens do STP:

1. Convergência lenta da topologia. Quando a topologia da rede muda, o protocolo de árvore de abrangência leva de 50 a 52 segundos para concluir a convergência da topologia.

2. Não oferece a função de balanceamento de carga. Quando há um loop na rede, o protocolo Spanning Tree só pode bloquear o loop, impedindo o encaminhamento de pacotes de dados e desperdiçando recursos da rede.

Virtualização e desafios do tráfego leste-oeste

Após 2010, com o objetivo de melhorar a utilização dos recursos de computação e armazenamento, os centros de dados começaram a adotar a tecnologia de virtualização, e um grande número de máquinas virtuais passou a surgir na rede. A tecnologia de virtualização transforma um servidor em múltiplos servidores lógicos, cada máquina virtual podendo ser executada independentemente, com seu próprio sistema operacional, aplicativos, endereço MAC e endereço IP independentes, e conectando-se a entidades externas por meio de um switch virtual (vSwitch) interno ao servidor.

A virtualização tem um requisito complementar: a migração a quente de máquinas virtuais, ou seja, a capacidade de mover um sistema de máquinas virtuais de um servidor físico para outro, mantendo o funcionamento normal dos serviços nas máquinas virtuais. Esse processo não interfere no uso pelos usuários finais, permitindo que os administradores aloquem recursos do servidor com flexibilidade ou realizem reparos e atualizações em servidores físicos sem afetar o uso normal pelos usuários.

Para garantir que o serviço não seja interrompido durante a migração, é necessário que não apenas o endereço IP da máquina virtual permaneça inalterado, mas também que o estado de execução da máquina virtual (como o estado da sessão TCP) seja mantido durante a migração. Portanto, a migração dinâmica da máquina virtual só pode ser realizada no mesmo domínio de camada 2, e não entre domínios de camada 2 diferentes. Isso cria a necessidade de domínios de camada 2 maiores, desde a camada de acesso até a camada central.

Na arquitetura tradicional de grandes redes de camada 2, o ponto de divisão entre as camadas 2 e 3 está no switch central. O data center abaixo do switch central constitui um domínio de broadcast completo, ou seja, a rede de camada 2. Dessa forma, é possível implementar dispositivos de maneira arbitrária e migrar entre locais, sem a necessidade de modificar a configuração de IP e gateway. As diferentes redes de camada 2 (VLANs) são roteadas através dos switches centrais. No entanto, nessa arquitetura, o switch central precisa manter uma enorme tabela MAC e ARP, o que impõe altos requisitos de capacidade. Além disso, o switch de acesso (TOR) também limita a escalabilidade da rede como um todo. Esses fatores acabam limitando a escalabilidade, a capacidade de expansão e a elasticidade da rede, além de causar problemas de latência no escalonamento entre as três camadas, o que pode não atender às necessidades futuras dos negócios.

Por outro lado, o tráfego leste-oeste gerado pela tecnologia de virtualização também traz desafios para a rede tradicional de três camadas. O tráfego de data center pode ser dividido nas seguintes categorias:

Tráfego norte-sul:Tráfego entre clientes externos ao centro de dados e o servidor do centro de dados, ou tráfego do servidor do centro de dados para a Internet.

Tráfego leste-oeste:Tráfego entre servidores dentro de um mesmo centro de dados, bem como tráfego entre diferentes centros de dados, como recuperação de desastres entre centros de dados e comunicação entre nuvens privadas e públicas.

A introdução da tecnologia de virtualização torna a implantação de aplicativos cada vez mais distribuída, e o "efeito colateral" é o aumento do tráfego leste-oeste.

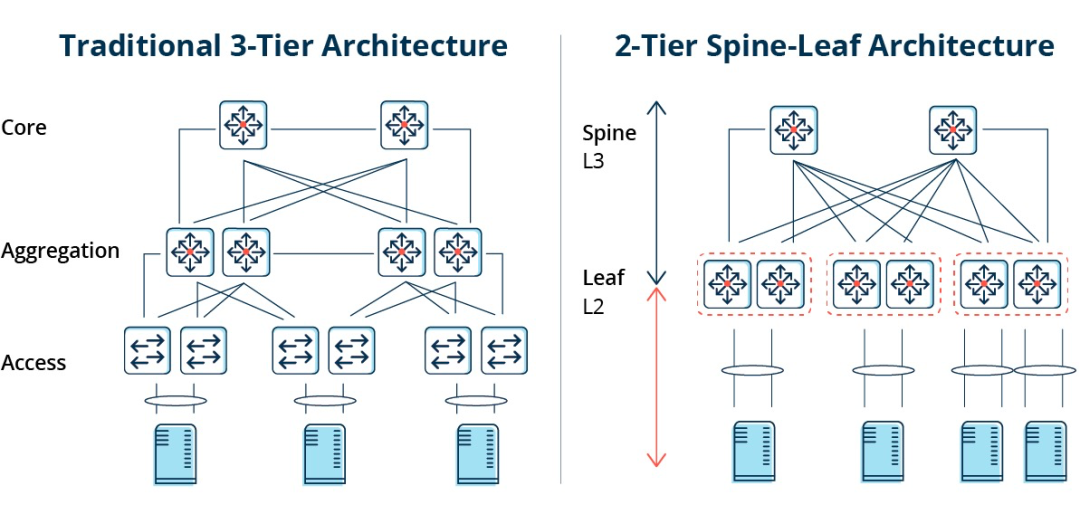

As arquiteturas tradicionais de três níveis são normalmente projetadas para tráfego Norte-Sul.Embora possa ser usado para tráfego leste-oeste, pode acabar não funcionando como deveria.

Arquitetura tradicional de três níveis versus arquitetura espinha-folha.

Em uma arquitetura de três camadas, o tráfego leste-oeste precisa ser encaminhado por meio de dispositivos nas camadas de agregação e núcleo, passando desnecessariamente por muitos nós. (Servidor -> Acesso -> Agregação -> Switch de Núcleo -> Agregação -> Switch de Acesso -> Servidor)

Portanto, se um grande volume de tráfego leste-oeste passar por uma arquitetura de rede tradicional de três camadas, os dispositivos conectados à mesma porta do switch podem competir pela largura de banda, resultando em tempos de resposta ruins para os usuários finais.

Desvantagens da arquitetura de rede tradicional de três camadas

É possível observar que a arquitetura de rede tradicional de três camadas apresenta muitas deficiências:

Desperdício de largura de banda:Para evitar loops, o protocolo STP geralmente é executado entre a camada de agregação e a camada de acesso, de forma que apenas um uplink do switch de acesso realmente transporte tráfego, e os outros uplinks sejam bloqueados, resultando em desperdício de largura de banda.

Dificuldade na implantação de redes em larga escala:Com a expansão da escala da rede, os centros de dados estão distribuídos em diferentes localizações geográficas, as máquinas virtuais precisam ser criadas e migradas para qualquer lugar, e seus atributos de rede, como endereços IP e gateways, permanecem inalterados, o que exige o suporte de uma camada 2 robusta. Na estrutura tradicional, nenhuma migração pode ser realizada.

Falta de tráfego leste-oeste:A arquitetura de rede de três camadas foi projetada principalmente para tráfego Norte-Sul, embora também suporte tráfego Leste-Oeste, porém suas desvantagens são evidentes. Quando o tráfego Leste-Oeste é intenso, a pressão sobre os switches das camadas de agregação e núcleo aumenta consideravelmente, limitando o tamanho e o desempenho da rede a essas camadas.

Isso faz com que as empresas se deparem com o dilema entre custo e escalabilidade:Suportar redes de alto desempenho em larga escala exige um grande número de equipamentos nas camadas de convergência e núcleo, o que não só acarreta altos custos para as empresas, como também requer um planejamento prévio da rede durante sua construção. Quando a escala da rede é pequena, ocorre desperdício de recursos, e quando a escala da rede continua a se expandir, a expansão torna-se difícil.

A arquitetura de rede espinha-folha

O que é a arquitetura de rede Spine-Leaf?

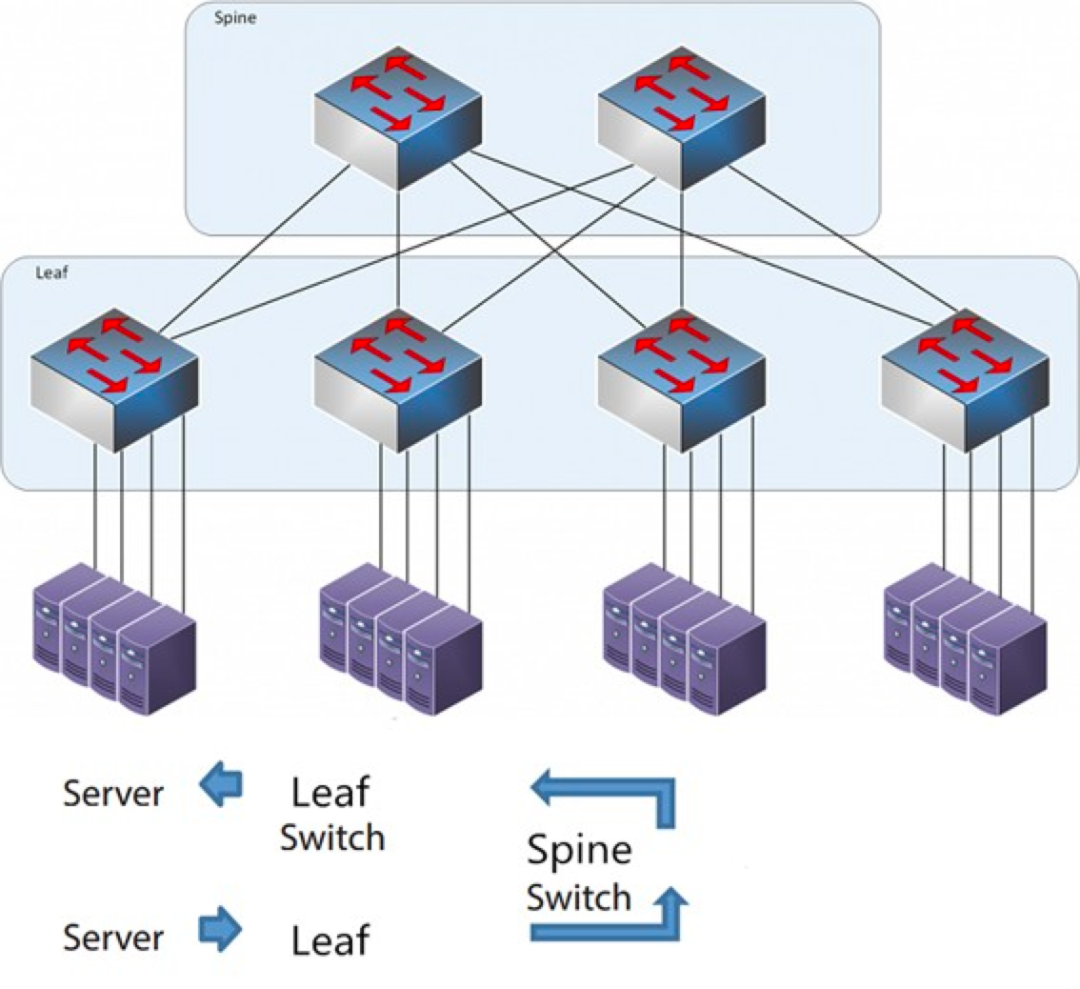

Em resposta aos problemas acima mencionados,Surgiu um novo modelo de data center, a arquitetura de rede Spine-Leaf, que também chamamos de rede leaf-ridge.

Como o nome sugere, a arquitetura possui uma camada Spine e uma camada Leaf, incluindo switches spine e switches leaf.

A arquitetura espinha-folha

Cada interruptor de folha está conectado a todos os interruptores de crista, que não estão diretamente conectados entre si, formando uma topologia de malha completa.

Na arquitetura spine-and-leaf, uma conexão de um servidor para outro passa pelo mesmo número de dispositivos (Servidor -> Leaf -> Switch Spine -> Switch Leaf -> Servidor), o que garante uma latência previsível. Isso ocorre porque um pacote precisa passar apenas por um switch spine e outro leaf para chegar ao destino.

Como funciona o sistema Spine-Leaf?

Switch Leaf: Equivalente ao switch de acesso na arquitetura tradicional de três camadas, conecta-se diretamente ao servidor físico como TOR (Top of Rack). A diferença em relação ao switch de acesso é que o ponto de demarcação da rede L2/L3 agora está no switch Leaf. O switch Leaf está acima da rede de camada 3 e abaixo do domínio de broadcast L2 independente, o que resolve o problema de BUM (Buffered User-Mounted) das grandes redes de camada 2. Se dois servidores Leaf precisarem se comunicar, eles devem usar roteamento L3 e encaminhar a comunicação através de um switch Spine.

Switch Spine: Equivalente a um switch de núcleo. O ECMP (Equal Cost Multi Path) é usado para selecionar dinamicamente múltiplos caminhos entre os switches Spine e Leaf. A diferença é que o Spine agora simplesmente fornece uma rede de roteamento L3 resiliente para o switch Leaf, permitindo que o tráfego norte-sul do data center seja roteado a partir do switch Spine em vez de diretamente. O tráfego norte-sul pode ser roteado do switch de borda, paralelamente ao switch Leaf, para o roteador WAN.

Comparação entre a arquitetura de rede Spine/Leaf e a arquitetura de rede tradicional de três camadas.

Vantagens do sistema espinha-folha

Plano:Um design plano encurta o caminho de comunicação entre servidores, resultando em menor latência, o que pode melhorar significativamente o desempenho de aplicativos e serviços.

Boa escalabilidade:Quando a largura de banda é insuficiente, aumentar o número de switches de crista pode estender a largura de banda horizontalmente. Quando o número de servidores aumenta, podemos adicionar switches de borda se a densidade de portas for insuficiente.

Redução de custos: Tráfego no sentido norte-sul, tanto saindo dos nós de borda quanto dos nós de crista. Fluxo leste-oeste, distribuído por múltiplos caminhos. Dessa forma, a rede de borda pode utilizar switches de configuração fixa sem a necessidade de switches modulares caros, reduzindo assim os custos.

Baixa latência e prevenção de congestionamento:Em uma rede Leaf Ridge, os fluxos de dados têm o mesmo número de saltos em toda a rede, independentemente da origem e do destino, e quaisquer dois servidores são alcançáveis entre si com três saltos, de Leaf para Spine e de volta para Leaf. Isso estabelece um caminho de tráfego mais direto, o que melhora o desempenho e reduz gargalos.

Alta segurança e disponibilidade:O protocolo STP é utilizado na arquitetura de rede tradicional de três camadas, e quando um dispositivo falha, ocorre a reconvergência, o que afeta o desempenho da rede ou até mesmo a sua falha. Na arquitetura leaf-ridge, quando um dispositivo falha, não há necessidade de reconvergência, e o tráfego continua a passar por outros caminhos normais. A conectividade da rede não é afetada, e a largura de banda é reduzida apenas em um caminho, com pouco impacto no desempenho.

O balanceamento de carga via ECMP é ideal para ambientes que utilizam plataformas de gerenciamento de rede centralizadas, como SDN. O SDN permite simplificar a configuração, o gerenciamento e o redirecionamento do tráfego em caso de bloqueio ou falha de link, tornando a topologia de malha completa com balanceamento de carga inteligente uma forma relativamente simples de configurar e gerenciar.

No entanto, a arquitetura Espinha-Folha apresenta algumas limitações:

Uma desvantagem é que o número de switches aumenta o tamanho da rede. O data center com arquitetura de rede leaf-ridge precisa de um número crescente de switches e equipamentos de rede proporcionalmente ao número de clientes. À medida que o número de hosts aumenta, um grande número de switches leaf é necessário para a conexão com o switch ridge.

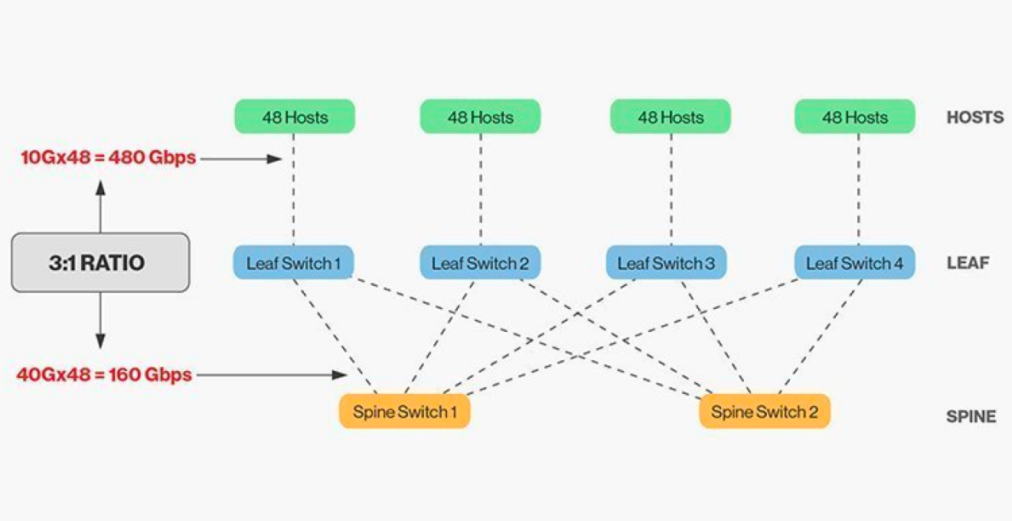

A interconexão direta de switches de crista e de folha requer compatibilidade e, em geral, a relação de largura de banda razoável entre switches de folha e de crista não pode exceder 3:1.

Por exemplo, imagine que existam 48 clientes com taxa de 10 Gbps no switch leaf, com uma capacidade total de porta de 480 Gb/s. Se as quatro portas de uplink de 40G de cada switch leaf forem conectadas ao switch ridge de 40G, a capacidade de uplink será de 160 Gb/s. A proporção é de 480:160, ou 3:1. Os uplinks de data centers são tipicamente de 40G ou 100G e podem ser migrados ao longo do tempo, partindo de 40G (Nx 40G) para 100G (Nx 100G). É importante observar que o uplink deve sempre operar em uma velocidade maior que o downlink para evitar o bloqueio da conexão.

As redes Spine-Leaf também têm requisitos de cabeamento bem definidos. Como cada nó leaf precisa ser conectado a cada switch spine, é necessário instalar mais cabos de cobre ou fibra óptica. A distância da interconexão aumenta o custo. Dependendo da distância entre os switches interconectados, o número de módulos ópticos de alta qualidade exigidos pela arquitetura Spine-Leaf é dezenas de vezes maior do que o da arquitetura tradicional de três camadas, o que eleva o custo total de implantação. No entanto, isso impulsionou o crescimento do mercado de módulos ópticos, especialmente para módulos ópticos de alta velocidade, como 100G e 400G.

Data da publicação: 26/01/2026